Elon Musk discussing the dangers of centralized AI with Sam Altman (CEO of OpenAI), in 2016.

— Tesla Hype (@TeslaHype) March 25, 2023

Fate loves irony. pic.twitter.com/SloROu48mb

A

A

Elon Musk : L’IA risque vraiment de tous nous tuer

lun 03 Avr 2023 ▪

17

min de lecture ▪ par

S'informer

▪

« Nous demandons à tous les laboratoires d’intelligence artificielle d’interrompre immédiatement, pour une durée d’au moins six mois, la formation de systèmes d’intelligence artificielle plus puissants que le GPT-4. ». C’est ainsi que commence la lettre ouverte cosignée par Elon Musk et plusieurs chercheurs en IA cette semaine. Le patron de Tesla craint en effet que l’IA puisse anéantir toute forme de vie biologique sur Terre.

Tout s’est accéléré avec ChatGPT

À la suite des progrès fulgurants observés ces derniers mois dans le domaine de l’IA grâce aux modèles de langage, de plus en plus de gens issus du monde de la tech ont commencé à exprimer leurs craintes sur le potentiel destructeur de l’IA. Surtout, le lancement de ChatGPT par OpenAI, détenu largement par Microsoft, a marqué le début d’une intense concurrence entre les géants du numérique.

Google a mis en place un plan d’urgence en rappelant Larry Page et Serguei Brin, Meta et Baidu ont lancé leur propre produit. Les GAFAM ont compris que l’IA pourrait rebattre les cartes dans les années à venir et qu’il s’agit sans doute de la technologie la plus disruptive du siècle, voire de l’histoire de l’humanité.

Des dizaines de milliards vont être investies et les VCs, les pom-pom girls de la finance comptent eux aussi participer à la danse. Autant dire qu’avec un tel niveau de concurrence, les enjeux d’éthique et de sécurité de l’IA deviennent secondaires.

Elon Musk regrette d’avoir financé OpenAI

Ironie de l’histoire. Si vous ne le saviez pas, OpenAI n’avait pas initialement pour but de booster les logiciels de la suite Office ou de redonner une jeunesse à Bing. Absolument pas. Si Elon Musk et Sam Altman (l’actuel CEO d’OpenAI) ont lancé le projet en 2015, c’était justement pour financer la recherche en sécurité de l’IA.

Musk, angoissé depuis l’enfance par la disparition de l’humanité a donc financé une entreprise qui n’avait pas pour but de faire du profit mais plutôt d’éviter une catastrophe. C’est notamment la lecture de Superintelligence, de Nick Bostrom qui a poussé Musk à soutenir la recherche en sécurité de l’IA. Après tout, si une IA nous éliminait tous, il ne serait plus possible d’aller sur Mars pour « étendre la conscience humaine ». Il s’agissait donc d’être légèrement précautionneux face à un risque existentiel, certes peu probable, mais au coût infini.

Quelques années plus tard, OpenAI, lance ChatGPT et inaugure l’ère de l’hyperconcurrence en matière d’IA. À partir de maintenant, les gens sont admiratifs devant le nouveau Dieu et demandent toujours plus de miracles.

Les GAFAM sont incitées à aller de plus en vite dans cette course, à balancer toujours plus de modèles d’IA de manière publique, et donc à mettre de côté les enjeux de sécurité. Malgré les scandales éthiques liés à l’évolution de Bing (et de son IA Sydney), nous avons pu voir que Microsoft n’était même pas impacté au niveau boursier. Le marché veut l’IA à n’importe quel prix.

Sam Altman : un fou furieux ?

Concernant, Sam Altman, c’est un drôle de personnage. S’il reconnaît le risque inhérent au développement de l’IA, il a également déclaré il y a quelques années : « le risque que l’IA nous tue tous à la fin est très élevé, mais en attendant, cela créera de grandes entreprises ». Plus récemment, il a admis qu’il était « possible que l’IA nous tue tous et qu’il ne fallait pas écarter cette possibilité ».

C’est également, le même individu qui dénigrait Bitcoin pour nous vendre à la place sa dystopie orwellienne Worldcoin. En gros, il s’agit d’une machine qui scanne votre iris pour vous permettre de recevoir votre salaire universel (car l’IA vous aura remplacé et volé votre travail).

Une lettre ouverte signée par Elon Musk et des pointures de l’IA

La lettre ouverte du Future of Life institute a été signée par des éminences de l’IA comme Stuart Russell, Yoshua Bengio, Daio Aomedei, Jan Leike, ou encore Shane Legg mais aussi des entrepreneurs de la tech comme Steve Wozniak et Elon Musk (qui même s’ils ne sont pas spécialisés dans l’IA, discutent avec les personnes les plus intelligentes de la planète). Plusieurs chercheurs en IA qui ont travaillé chez Deepmind et ont pratiqué la recherche dans les meilleures universités du monde comme Oxford ont participé à cette initiative.

C’est la ligne des « doomers » pour reprendre les récentes attaques de Yann Le Cun, un chercheur français en IA très renommé et qui pense que ces inquiétudes ne sont pas fondées pour le moment, car les modèles de langage ne risquent pas de conduire à une IA de niveau humain.

Bref, ceux qui ont signé cette lettre ouverte ne sont pas des hurluberlus et c’est ce qui est inquiétant.

« Devons-nous risquer de perdre le contrôle de notre civilisation ? De telles décisions ne doivent pas être déléguées à des leaders technologiques non élus. Des systèmes d’IA puissants ne devraient être développés que lorsque nous sommes certains que leurs effets seront positifs et que leurs risques seront gérables.», Lettre ouverte.

« Par conséquent, nous demandons à tous les laboratoires d’IA d’interrompre immédiatement, pendant au moins six mois, la formation de systèmes d’IA plus puissants que le GPT-4. », Lettre ouverte.

« Il n’est pas inconcevable que l’IA nous anéantisse tous »

Geoffrey Hinton, l’un des pères du deep learning, qui travaille actuellement chez Google a récemment déclaré « qu’il n’était pas inconcevable » que l’IA se développe au point de constituer une menace pour l’humanité.

« Jusqu’à il y a peu, je pensais qu’il faudrait entre 20 et 50 ans pour que nous disposions d’une IA généraliste. Aujourd’hui, je pense que ce sera dans 20 ans ou moins… Je pense qu’il n’est pas inconcevable que l’IA anéantisse l’humanité. C’est tout ce que je dirai… C’est un problème. Nous devons réfléchir sérieusement à la manière de contrôler cela.», Geoffrey Hinton.

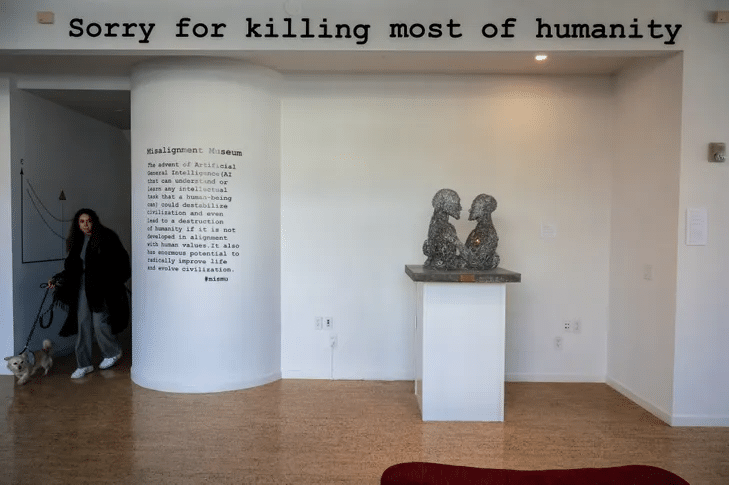

IA : un problème d’alignement

L’un des principaux risques identifiés est le problème de l’alignement des valeurs, c’est-à-dire la difficulté de s’assurer que les objectifs d’une IA ou d’une AGI correspondent aux valeurs des êtres humains. Un alignement imparfait pourrait donc entraîner des conséquences indésirables, voire catastrophiques. Par exemple, une AGI mal alignée pourrait optimiser un objectif sans tenir compte des répercussions sur la société, l’environnement ou la vie humaine.

Orthogonalité

L’autre thèse souvent mentionnée est celle de l’orthogonalité. Selon cette théorie, l’intelligence (c’est-à-dire la capacité à résoudre des problèmes de manière efficace) est indépendante des objectifs finaux.

Autrement dit, il serait possible de créer une AGI très intelligente qui n’adoptera pas naturellement des valeurs humaines. L’alignement est donc important pour éviter une catastrophe du genre : vous programmez une IA pour maximiser la production de trombones dans une entreprise et celle-ci se met à s’accaparer toute l’énergie sur Terre et décide d’anéantir l’humanité afin de réaliser plus efficacement cet objectif bancal. Et si l’IA considère qu’il y a un risque que nous l’éteignions – ce qui l’empêcherait de mener correctement son objectif – alors, elle pourrait nous exterminer encore plus rapidement.

Au-delà des risques liés au développement d’une superintelligence ou d’une AGI, de nouveaux risques liés à une IA du niveau de GPT4 apparaissent déjà. ChatGPT peut, par exemple, être utilisé à des fins malveillantes comme des actes de cybercriminalité. Grâce aux LLM, il est désormais plus simple pour des escrocs de pratiquer le phishing ou encore de remplir des captchas.

« L’IA ne vous aime pas et ne vous déteste pas, mais vous êtes composé d’atomes qu’elle peut utiliser pour autre chose. », E. Yudkowski.

« Si quelqu’un construit une IA trop puissante, dans les conditions actuelles, je m’attends à ce que chaque membre de l’espèce humaine et toute vie biologique sur Terre meurent peu de temps après.» E. Yudkowski

IA : des risques sociaux et psychologiques

Bien sûr, ces risques ne tiennent pas compte des problématiques sociales et psychologiques que pourraient engendrer la généralisation de l’IA. En tant qu’être humain, accepterons-nous psychologiquement de vivre avec des entités largement plus intelligentes que nous ? Accepterons-nous de voir nos savoirs, dont l’imagination et l’esprit de créativité qui nous paraissaient si humain être accaparés par des machines ?

Certes, même si les signataires de cette tribune se trompent et que l’IA parvient à être domptée, nous perdrons en autonomie et en liberté, devenant chaque jour un peu plus dépendant du système technologique global et perdant nos facultés intellectuelles qui « faisaient croire en notre génie ».

Nous perdons toutes les facultés que nous n’entraînons pas. De même, que notre hyperspécialisation nous contraint d’appeler un plombier lorsque notre robinet est en panne, que nous allons chez le retoucheur pour recoudre un bouton et que nous restons chez nous lorsqu’une grève nous prive de transports, nous serons tout aussi angoissés lorsque demain ChatGPT sera dysfonctionnel. Nous deviendrons dépendant de lui pour écrire des mails synthétiques, lire du contenu dépassant 20 pages ou produire des œuvres artistiques.

Tous aliénés, tous prolétarisés par les IA, tous au service de la Mégamachine ?

Game Theory et course infernale à l’IA

L’un des principaux problèmes liés au développement de l’IA est que très peu d’acteurs ont intérêt pour l’instant à cesser de financer la recherche dans cette discipline. Ou à se mettre à financer abondamment les travaux en sécurité de l’IA.

Microsoft a intérêt de continuer à injecter des milliards « pour faire danser Google » comme l’explique son CEO Satya Nadella. Google a intérêt de mettre les bouchées doubles pour contenir Bing. Meta a intérêt de lancer de nouveaux produits pour sortir la tête de l’eau alors que sa stratégie metaverse semble être un échec.

La Russie, dont Vladimir Poutine disait il y a quelques années que celui qui contrôlerait l’IA, aura le contrôle du monde ne va certainement pas s’asseoir sur la même table que des dirigeants européens pour réguler l’IA. Le PCC, ne compte pas laisser les États-Unis s’approprier cette technologie et continuera de soutenir ses entreprises. Les États-Unis n’accepteront pas de renoncer à l’IA, si la Chine n’abandonne pas.

Les hommes politiques et les citoyens qui veulent plus de croissance économique et continuer de consommer davantage à des prix toujours plus bas réclameront plus d’IA.

Bref, la régulation de l’IA semble encore plus compliquée que celle des armes nucléaires et aucun consensus mondial ne semble se dégager actuellement pour éviter un « cygne noir » apocalyptique. L’IA crache de l’or et c’est pourquoi tout le monde veut s’en emparer.

Cette course effrénée à l’AGI va pourtant augmenter les risques, car les acteurs seront moins enclins à investir le temps et les ressources nécessaires pour résoudre correctement le problème de l’alignement des valeurs.

Bitcoin face à l’IA

Dans la sphère crypto, des personnes comme Vitalik Buterin ou encore Arthur Breitman, le fondateur de Tezos, sont sur la ligne « doomers ». Pas étonnant. La blockchain est une assurance contre l’autoritarisme, la tyrannie et la spoliation. Les crypto boys sont naturellement plus conservateurs.

Je pense que les authentiques cypherpunks dont le combat pouvait se résumer par le terme « d’autonomie » s’opposeraient au développement de l’IA. Enfin, ceux qui placent la liberté individuelle au-dessus du progrès technologique et du confort. N’oublions pas que la technique est tout autant (voire davantage) une menace à la liberté que l’État et qu’il convient de se méfier de ces deux objets si l’on ne souhaite pas se faire écraser le visage par leur botte.

Les fake news, la diffusion d’images trompeuses comme cette récente photo du Pape François qui a fait le tour du monde risque bien d’estomper un peu plus la notion de Vérité au 21e siècle. Ne soyez pas naïf, tous ces nouveaux risques conduiront à terme à la perte de l’anonymat sur internet et nous devrons répondre à de nouvelles exigences bureaucratiques pour cohabiter avec les IA. C’est incontournable pour la paix sociale et les bureaucrates produiront de nouveaux Cerfa.

Un combat pour l’autonomie

Bitcoin a pour ambition de redonner aux individus de l’autonomie, du contrôle sur leur argent, leur propriété et leur vie face à l’État et aux mégacorporations bancaires. Elle leur permet de mener un combat politique, sans craindre la censure économique.

L’IA est radicalement différente. Sa nature hautement centralisée conduira au contraire à écraser l’individu et à donner plus de pouvoirs aux GAFAM et aux États. Ces structures disposeront d’une puissance supplémentaire pour capter l’attention des individus et contrôler leurs désirs plus efficacement grâce à la force de persuasion du langage avec les stéroïdes de ChatGPT.

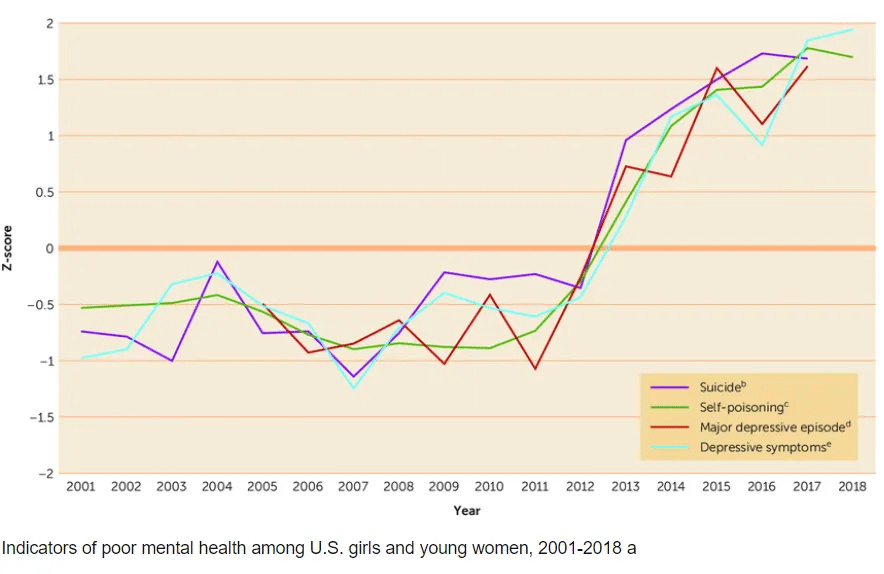

Ils nous promettent la société des loisirs où l’IA aura remplacé le travail. Nous aurons 7 milliards de dépressifs qui n’ayant plus de contrôle sur les moyens, passeront leurs journées sur TikTok à scroller des écrans pour recevoir des shots de dopamine. Heureusement, ChatGPT leur permettra plus rapidement de diagnostiquer leur dépression.

Il y a quelques années, Peter Thiel, disait « l’IA est communiste, la blockchain est anarchiste ». En effet, il mentionnait notamment l’exemple du Parti Communiste Chinois, prompt à interdire Bitcoin, mais adepte des technologies de reconnaissances faciales et du système de crédit social basé sur des algorithmes d’IA.

IA et hybris

Si Bitcoin s’apparente à une technologie conviviale au sens d’Illich, car elle accroît le pouvoir de l’homme sur son environnement et qu’elle lui redonne de la responsabilité dans sa gestion financière, l’IA est son antithèse : une technologie qui n’est plus à portée humaine, une « boîte noire ».

Bitcoin, la technologie qui tient en 8 pages parfaitement compréhensibles. L’IA, la matrice colossale de nombres décimaux à la portée d’aucun homme. Bitcoin, la technologie qui replace la limite (celle des 21 millions) au centre du jeu. L’IA, la technologie qui abolit les limites et qui pourrait bien nous faire pêcher par hybris.

« Nous ne sommes pas prêts. Nous ne sommes pas en passe d’être significativement plus prêts dans un avenir prévisible. Si nous poursuivons dans cette voie, tout le monde mourra, y compris des enfants qui n’ont pas choisi cette voie et qui n’ont rien fait de mal. » E. Yudkowski.

La lettre ouverte cosignée par Elon Musk a le mérite d’exporter le débat sur les risques de l’IA en dehors du microcosme de la Silicon Valley et de Twitter. Les risques sont certes extrêmement faibles pour leur moment, mais leurs coûts étant infinis, la prudence devrait être de mise. Le lancement de ChatGPT a inauguré une course infernale aux IA et 6 mois de moratoire semble être un délai extrêmement court pour résoudre le problème de l’alignement.

Maximisez votre expérience Cointribune avec notre programme 'Read to Earn' ! Pour chaque article que vous lisez, gagnez des points et accédez à des récompenses exclusives. Inscrivez-vous dès maintenant et commencez à cumuler des avantages.

A

A

Chaque jour, j’essaie d’enrichir mes connaissances sur cette révolution qui permettra à l’humanité d’avancer dans sa conquête de liberté.

DISCLAIMER

Les propos et opinions exprimés dans cet article n'engagent que leur auteur, et ne doivent pas être considérés comme des conseils en investissement. Effectuez vos propres recherches avant toute décision d'investissement.